[슬로우민트] 이효석 박사 추천 ‘좋은 책’ 이야기, 첫 번째 책 ‘감정은 어떻게 만들어지는가’ 네 번째 이야기:

- 구성주의의 반격: ‘감정은 어떻게 만들어지는가?’ (2017)

- 편도체-공포 가설과 옴니제닉 모델

- 인간은 불완전하다

- 빅테크의 표정-감정 연구는 낭비인가

- 소리는 실재하는가, 감정은 실재하는가

- 뇌, 이야기를 만들어 내는 기계

- 느낌을 측정할 수 있다면 (ft. 다윈과 스키너 비판)

감정은 어떻게 만들어지는가

민노씨가 묻고, 이효석 박사가 답하다

오늘날 있지도 않은 감정의 실체를 찾는 데 얼마나 많은 시간과 돈이 허비되고 있는지를 생각하면, 우리는 이런 망각 때문에 그만큼 더 가난해진 셈이다. 오늘날 마이크로소프트는 감정을 인식하겠다는 목표 아래 얼굴 사진을 분석한다. 애플은 최근에 인공지능 기법을 사용해 표정에서 감정을 탐지하는 기술을 개발 중인 이모션트(Emotient)라는 신생 기업을 인수했다.

몇몇 회사에서는 표정에서 감정을 탐지하는 프로그램을 구글 글래스에 적용해 자폐아를 돕는 장치를 개발 중이다. 스페인과 멕시코의 정치인들은 유권자의 표정에서 투표 선호도를 읽어낸다는 이른바 신경정치학에 관심을 보이고 있다. 이렇게 많은 사업가와 과학자가 여전히 본질주의에 몰두하는 동안 감정에 관한 가장 긴급한 몇몇 물음은 미해결된 채로 남아 있고, 중요한 물음들은 뒷전으로 밀려나고 있다.

리사 펠드먼 배럿, ‘감정은 어떻게 만들어지는가?’, 제8장 ‘인간 본성에 관한 새로운 견해’ 중 ‘심리학을 어지럽힌 행동주의’, 생각연구소: 2017. 중에서

민노: 책에서 굉장히 흥미로웠던 부분 중 하나가 애플이나 구글이나 마이크로소프트를 언급하는 부분입니다. 이런 세계적인 빅테크들이 표정-감정 인식 연구를 위해 지금 헛돈 쓰는 것일 수도 있어, 이렇게 비판적으로 리사 교수는 말하고 있는데요.

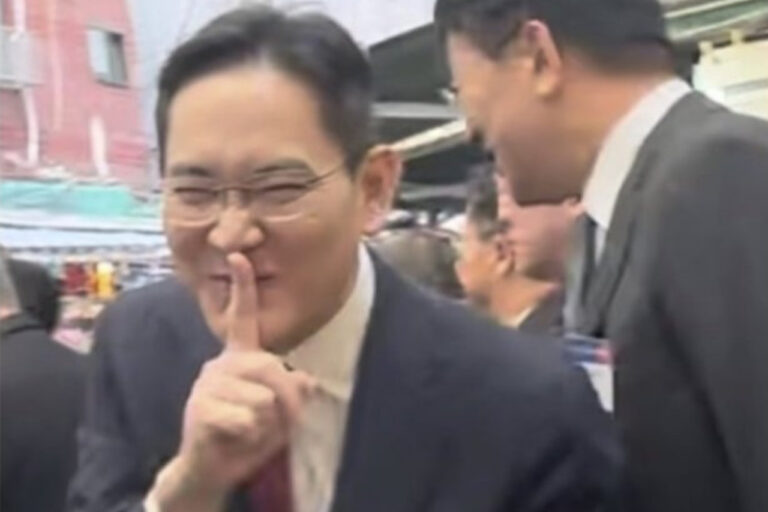

이효석: 저는 이 부분은 그렇게 생각하지 않고요. 제가 조금 관심 있는 부분이라 어느 정도를 말씀드릴 수 있습니다. 일단 표정으로 감정을 판단하는 문제의 경우, 우리가 일상적인 수준에서는 어떤 사람의 표정을 보고 그 사람이 슬퍼하는지 기뻐하는지는 알 수 있거든요. 그건 우리가 가진 상식이죠. 물론 이 책에 아주 인상적인 사진이 나옵니다. 약간 스포일러가 될 수 있으니 이 책이 주는 놀라움을 나중에 책을 읽을 때 온전히 느끼고 싶으신 분은 이번 문단을 건너뛰셔도 좋을 것 같습니다.

스포일러가 불안하면 다음 문단으로 건너뛰세요.

이효석: 책 초반에 한 흑인 여성이 어떤 극단적인 흥분 상태로 괴성을 지르는 표정을 찍은 사진(위 책 사진 참고)을 보여줍니다. 그리고 이 사람이 어떤 감정 상태에 있을지를 맞추어 보라고 말하지요. 분명 사진만으로는 이게 어떤 공포나 분노 감정을 느끼는 사람을 찍은 것처럼 보여요.

하지만 이 사진은 바로 여자 테니스계의 전설인 세레나 윌리암스가 자기 언니 비너스 윌리암스를 이긴 다음에 기쁨의 괴성을 지르는 모습을 찍은 사진입니다. 사진만으로는 그녀가 어떤 감정 상태에 있는지를 전혀 생각하기 어렵기 때문에 표정이 감정을 나타내지 않는다, 어떤 객관적으로 드러난 상태만으로 감정을 파악할 수 없다는 이 책의 주장을 뒷받침하는 아주 좋은 사진이라 생각하고요.

표정-감정 인식 연구, 낭비로 볼 수 없다고 생각

이효석: 하지만 그럼에도 불구하고, 일상적인 수준에서는 어느 정도의 높은 확률로 상대의 감정을 예측할 수 있다고 생각합니다. 우리가 대화할때 우리는 상대가 내 이야기에 어떻게 반응하는지를 실시간으로 관찰하며, 그 이야기를 계속할지 아니면 다른 주제를 꺼낸지를 판단하는 식으로 말이지요.

민노: 10개 중에 7개나 8개 정도 확률로 저 표정은 저런 감정에서 나온 표정일 거야라고 알 수도 있겠지만, 잘못 인식한 나머지 2~3개의 표정도 중요할 수 있잖아요.

이효석: 네, 그럴 수도 있습니다. 하지만 많은 경우 어떤 극단적인 케이스를 제외한 일반적인 반응만으로도 의미가 있을 수 있습니다.

예를 들어, TV에 카메라를 달아놓고 사람들의 반응을 살펴서 광고나 드라마에 대한 반응이나 효과를 측정할 수 있겠죠. 책에 나오듯이 선거철이라면 정치인이 화면에 나왔을 때 사람들의 반응(표정)을 통해 그 정치인에 대한 지지율을 예측할 수도 있고요.

스마트폰의 경우 훨씬 더 여러가지 가능성이 있습니다. 전면에 카메라가 있고 이 카메라가 우리 얼굴을 항상 보고 있으니까요. 우리가 보는 스마트폰으로 보는 모든 컨텐츠에 대한 우리의 반응을 측정할 수도 있습니다. 물론 우리의 표정 데이터를 사용하는 일을 우리가 허락해야겠지요. 어쨌든 그런 방식의 감정 연구는 당연히 의미가 있을 것 같고요.

물론 리사 펠드먼의 말처럼 같은 표정이나 반응에 대해서도 문화에 따라 다른 해석이 가능한 부분도 있습니다. 책에 나오듯, 보스톤 테러 사건 범인인 체첸계 미국인 테러리스트(조하르 차르나예프)는 자기 문화권(이슬람 수니파)에서는 무표정하게 담담하게 있는 행동이 남자다운 행동이기 때문에 가만히 있었던 건데 미국의 배심원들은 이 테러리스트가 반성을 하지 않는다고 생각했으니까요.

민노: 네, 책에서 그런 문화적 차이를 지적하죠.

메타버스 캐릭터가 ‘선글라스’ 많이 끼는 이유

이효석: 그리고 또 하나는 제가 개인적으로 관심이 많은 분야인데, VR의 경우 메타버스 안에서 돌아다니면 캐릭터의 눈에 선글라스를 끼도록 만들어 놓은 경우가 많습니다. 왜냐하면 그냥 눈을 드러낼 경우 상대방의 시선 방향을 우리가 어색하게 느끼게 되거든요. 그리고 눈을 정면에서 바라보는 게 묘한 기분을 느끼게도 만들고요. 또 지금 상황에 맞는 표정이 나타나게 만드는 것도 쉽지 않지요.

그래서 지금 애플이나 메타(페이스북)가 준비하고 있는 게 VR기기 안쪽에 카메라를 두고 눈을 촬영하는 겁니다. 그 카메라가 눈과 눈 주변 근육을 보고 이 사람 표정이 메타버스 안에서도 그대로 드러나게 만들어서 더 사실적인 상호작용을 할 수 있게 하는 거죠. 아직 입 모양을 카메라로 찍는다는 이야기는 들어본 적 없는데 입 까지 찍으면 표정을 더 완벽하게 보여줄 수 있겠죠.

여기에 목소리의 톤이나 대화 내용까지 어떤 식으로 학습한다면 더 완벽한 감정 파악도 가능하겠고요. 그때도 냉소적인 표현과 진짜 칭찬을 구별하는 것은 쉽지 않을 수도 있고요. 어쨌든, 메타버스에서 표정과 감정은 충분히 연구할 만한 주제라고 생각합니다.

민노: 그러면, 이 책에서는 빅테크가 표정 연구하는 것에 관해서는 리사 교수가 좀 과장했을까요. 아니면 너무 거칠게 서술했을까요. 돈 낭비하고 있다는 식으로 썼는데요. 어떻게 보세요?

이효석: 약간 그렇네요. 그렇지만 저는 그런 기술에 한계가 있을 것이라는 정도의 의미로 리사 교수가 말했다고 생각합니다. 그럼에도 저는 그런 기술에 나름의 의미가 있다고 생각하는 정도이고요.

민노: 이게 제한적으로나마 의미가 있고 상업적인 효용성도 있을 수 있다. 그러니까 이론적으로 약점이 있기 때문에 100% 효용이 없다고 단정적으로 말하는 것은 좀 과장이다?

이효석: 아, 네 그 정도.

감정은 17세기 발명품?

감정에 대한 대다수 과학적 연구는 미국식 개념과 미국식 감정 단어를 사용해 번역되어 영어로 수행되었다. 저명한 언어학자 안나 비에르츠비카(Anna Wierzbicka)에 따르면 영어는 감정의 과학이 갇힌 개념적 교도소였다. “감정에 관한 영어 용어들은 민속적인 분류체계이지 문화와 상관없이 객관적인 분석틀이 아니다. 혐오, 공포, 수치심 같은 영어 단어가 마치 인간의 보편적인 개념이나 근본적인 심리적 실재를 밝히는 단서라도 되는 것처럼 그렇게 명백하게 가정해서는 안 된다.”

사태를 더욱 제국주의적으로 만드는 것은 이런 감정 단어가 20세기 영어에서 가져온 것이며 일부는 매우 현대적인 개념이라는 사실이다. 감정(emotion)이라는 개념 자체도 17세기의 발명품이다. 그 전에는 학자들이 약간 다른 의미를 지니는 ‘열정’(passion), ‘정취’(sentiment) 등의 개념을 사용했다.

리사 펠드먼 배럿, ‘감정은 어떻게 만들어지는가?’, 제7장 ‘감정은 사회적 실재다’ 중 ‘일곱 색깔 무지개와 여섯 색깔 무지개’, 생각연구소: 2017. 중에서

민노: “감정이라는 개념 자체도 17세기의 발명품이다.” 이런 표현까지 나오는데요.

이효석: 세네카가 쓴 [화에 대하여]라는 책이 있거든요.

민노: 세네카는 굉장히 옛날 사람이잖아요.

이효석: 네, 2천 년 전이죠. 그러니까 이 화(분노)라는 거는 아까 제가 말했던 어떤 개략적인 긍정, 부정 이 수준에서 구분할 수 있다고 하면 당연히 17세기 훨씬 전부터 있었던 거고요. 리사가 얘기한 17세기의 발명품이라는 건, 좀 더 풍부한 여러 감정들, 그러니까 책에서 ‘적소’(niche)라고 이야기하는 특정한 상황에서의 행동 양식이나 느낌을 감정이라는 것으로 분류하고 이를 특별하게 취급하기 시작했다, 그런 말일 수는 있겠죠.

아기의 패턴 학습

페이 쉬와 그의 학생들은 이것을 실험적으로 증명하기 위해 생후 10개월 된 아기들에게 물체를 보여주면서 물체마다 ‘욱’, ‘닥’ 같은 무의미의 이름을 부여했다. 제시된 물체는 개 모양의 장난감, 물고기 모양의 장난감, 여러 색의 구슬이 달린 원기둥, 고무 꽃이 달린 직사각형 물체 등이 포함되어 있고, 서로 비슷한 점이 거의 없었다. 그리고 물체마다 종소리, 달가닥거리는 소리 같은 잡음을 냈다.

그러나 이런 상황에서도 아기들은 패턴을 학습했다. 상이한 물체에 걸쳐 똑같은 무의미의 이름을 들은 아기는 물체의 모양과 상관없이 이런 물체가 똑같은 잡음을 낼 것이라고 예상했다. 또 두 물체가 다른 이름을 가지고 있으면 다른 잡음을 낼 것이라고 예측했다. 아기가 단어의 소리를 바탕으로 물체가 똑같은 잡음을 낼지 아닐지를 예측했다는 점에 주목해야 한다.

이것은 단순한 물리적 외양을 넘어서는 패턴의 학습이기 때문이다. 단어는 아기로 하여금 상이한 것들을 등가로 표상하도록 자극함으로써 목표에 기초한 개념의 형성을 촉진한다. 실제로 관련 연구에 따르면 아기는 단어 없이 물리적 유사성으로 정의된 개념보다 단어를 제시했을 때 목표에 기초한 개념을 더 잘 학습한다.

리사 펠드먼 배럿, ‘감정은 어떻게 만들어지는가?’, 제5장 ‘개념과 단어의 통계학’ 중 ‘창조적 통계학자들’, 생각연구소: 2017. 중에서

민노: 아기들이 패턴 학습을 한다고 지적하잖아요. AI와 어떤 연관성이 있는 건가요? AI도 인간처럼 패턴 학습을 하는 건가요?

이효석: 네, 우선 AI라는 게 기본적으로 패턴을 찾는 것이고요. 사실 데이터에서 패턴을 찾는 것 자체는 통계나 기계학습이라는 이름으로 계속 있었고요. 어떤 수준의 패턴이냐가 중요할텐데, 최근 딥러닝 기반의 AI는 이미지나 소리와 같은 예전에는 잘 다루지 못했던 복잡한 패턴을 아주 잘 발견하게 되었기 때문에 여러 분야에서 놀라운 성능을 보이게 된 거고요.

그런 놀라운 성능의 이유로 사람들이 생각하는 것이, 이 딥러닝 기술이 인간 뇌의 뉴런을 흉내냈기 때문이 아닌가 하는 것이고요. 그러니까 뇌의 입장에서는 시각 신호나 청각 신호가 그저 어떤 전기 신호로 들어오는 것인데, 예를 들어 고양이를 매우 잘 구별하거든요. 고양이 모습의 패턴을 잘 구별해낸다는 말이죠. 그런 의미에서 AI도 인간처럼 패턴 학습을 한다 이렇게 말할 수도 있고요.

본문의 예는 장난감의 모양과 소리, 그리고 장난감의 이름을 아기들이 묶어서 패턴 학습을 하더라, 곧, 같은 이름의 장난감들은 같은 소리를 낼 것이라고 아기들도 예측했다는 것입니다.

한편으로, 초기의 딥러닝과 사람의 뇌 사이에 차이가 많았죠. 예를 들어, 아이는 고양이 몇 마리만 만져봐도 아니면 실제로 보지도 않고, 그냥 영상으로만 봐도 고양이를 알잖아요. 그런데 AI는 고양이를 구분하기 위해서는 고양이 사진 몇 만 장을 학습시켜야만 했죠. 그래서 인간과는 큰 차이가 있다고 했거든요.

그런데 최근에 나오는 ‘퓨샷 러닝’(few-shot learning)이라는 기술은 고양이 사진을 몇 장 안 넣어도, 물론 그 그전에 고양이가 아니라 개에 관해서 학습을 많이 해놓으면, 사실 개랑 고양이는 다른 점도 많지만, 비슷한 점도 훨씬 많잖아요. 그렇게 고양이 사진을 예전처럼 몇 만 장이 아니라 아주 적게 몇백 장 몇십 장만 가지고도 고양이를 구별할 수 있게 하는 그런 기술들이 나오고 있는데요. 그런 걸 보면 인간 아기의 뇌 안에 기본적인 인간의 형태라든지 동물의 형태라든지 이런 지식이 들어 있다고 하면 그거랑 AI랑 좀 비슷하지 않느냐는 식의 이야기도 있습니다.