[번역자 구함 02.] 비언론인 최초로 안종필 자유언론상 대상을 받은 김보라미(변호사, 디케)가 아직 한글로 나오진 않았지만 함께 나누고 싶은 책을 소개합니다. (⌚6분)

📕 오늘 함께 나누고 싶은 책: ‘AI 뱀 기름’

- AI 뱀 기름: AI가 할 수 있는 일과 할 수 없는 일, 그리고 그사이의 차이를 구별하는 법(아르빈드 나라야난, 사야시 카푸르)

- AI Snake Oil: What Artificial Intelligence Can Do, What It Can’t, and How to Tell the Difference (written by Arvind Narayanan, Sayash Kapoor)

작동하지 않거나 사회에 해악을 끼치는 ‘AI 뱀 기름’

대선 시기다. 주요 후보들이 AI 정책 공약을 앞다투어 제시한다. 하지만 구체적으로 무엇을 어떻게 실현하겠다는 것인지는 여전히 불분명하기만 하다. 판결문조차 제대로 공개하지 않는 사법부마저 ‘사법부 인공지능위원회(위원장 이숙연 대법관)’를 지난달 출범시키며 AI 기반 사법 정보화를 위한 로드맵 수립에 나섰다.

이처럼 여러 분야에서 인공지능 도입이 가속화되는 가운데, 프린스턴대 컴퓨터공학과 아르빈드 나라야난(Arvind Narayanan)과 사야시 카푸르(Sayash Kapoor)는 작동하지 않을 뿐만 아니라 사회에 해악을 끼치는 AI 서비스들을 날카롭게 분석했다.

두 저자의 공동 집필은 프린스턴대에서 시작되었다. 프린스턴대 컴퓨터공학과 아르빈드 나라야난과 사회학과 매튜 살가닉(Matthew Salganik)이 팀을 이뤄 ‘예측의 한계(Limits to Prediction)’라 불리는 강의를 개설하면서부터다. 이 강의는 인공지능으로 미래를 예측하기 어려운 이유를 설명하는 기초연구를 다뤘다.

수강생들은 연구에 참여할 수 있었는데, 그중 한 명이 페이스북에서 근무하다가 프린스턴대 박사과정에 막 입학한 사야시 카푸르였다. 두 저자는 4년간 공동연구를 통해 얻은 통찰을 이 책에 담았다.

‘뱀 기름(snake oil)’은 19세기 말~20세기 초 미국에서 모든 병을 치료한다며 판매된 만병통치약을 통칭한다. 성분도 불분명하고 과학적 근거도 없는 이 약물은 때로는 생명에 해를 끼치기도 했다. 1906년 식품의약국(FDA)이 설립되기 전까지 뱀 기름 판매업자는 제품의 내용물, 효능, 안전성에 대해 어떤 책임도 지지 않았다.

저자들이 인공지능을 뱀 기름에 비유한 것은 AI 기술 자체를 깎아내리려는 것이 아니다. 오히려 AI가 이룬 놀라운 기술적 진전을 인정하면서도, 동시에 존재하는 수많은 결함이 존재하는 AI에 대한 경각심을 불러일으키고자 한 것이다.

예측형 AI의 사회적 해악: 체계적 배재와 불이익 집중

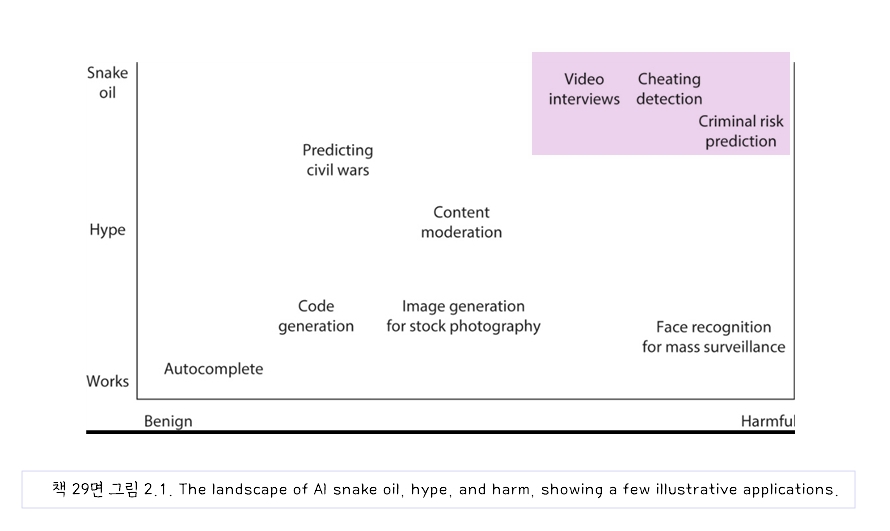

책 29면의 그래프는 ‘AI 뱀 기름’, 과대광고, 해악의 실상을 한눈에 보여준다. 저자들은 이 문제가 본질적 결함으로 인한 것이어서 시간이 지난다고 개선되지 않을 것이라고 단언한다.

예측형 AI를 판매하는 기업들은 알고리즘으로 미래를 정확히 예측할 수 있다고 주장하지만, 실제로는 예측이 빗나갈 뿐만 아니라 사회에 해악을 끼치고 있다. 대표적 사례가 네덜란드의 복지 사기 예측 알고리즘이다. 약 6년간 운영된 이 시스템의 피해자는 네덜란드어를 구사하지 못하는 여성과 이민자가 표적이 되었다. 그 알고리즘의 세부 사항이 공유되었을 때 2021년 총리와 전체 내각이 사임할 정도로 대중의 분노가 컸다.

이런 문제는 네덜란드에 국한되지 않는다. 미국 미시간주는 2013년부터 2015년까지 2,100만 달러를 잘못 징수했다. 호주 정부 역시 로보데트(Robodebt) 스캔들로 2016년부터 2020년까지 시민들로부터 7억 2,100만 호주 달러를 잘못 징수했다.

이러한 예측형 AI의 가장 심각한 문제는 효과가 없을 뿐만 아니라 그 피해가 특정 그룹, 즉 과거에 체계적으로 배제되고 불이익을 받은 그룹에 불균형적으로 집중된다는 점이다.

데이터 누출∙액세스 저널리즘∙의인화∙사유화

인공지능 연구 분야에서도 심각한 문제가 발견된다. 저자들은 특히 ‘데이터 누출(data leakage)’ 문제를 지적한다. 이는 AI 도구가 훈련에 사용된 것과 동일하거나 유사한 데이터로 평가받아 정확도가 과장되는 현상으로, 마치 시험 전에 답을 알려주고 평가하는 것과 같다.

이런 교과서적 오류가 머신러닝 연구에 매우 흔했고, 컴퓨터과학 전문 교육을 받지 않은 연구자들이 머신러닝을 기성품으로 사용할 때 더욱 빈번하게 발생했다. 저자들은 연구 주제가 더 주목받을수록 품질이 더 나빠진다고 지적했다. 실제로 저자들은 주목받았던 COVID-19를 탐지를 위한 흉부 엑스레이와 영상 데이터 연구 중 400개 이상의 논문을 검토했는데 그 중 어느 것도 임상적으로 유용하지 않았다고 평가했다.

언론은 ‘AI 뱀 기름’ 확산의 핵심 요인 중 하나로 지목된다. 많은 AI 전문 기자들이 대형 기술기업과의 관계 유지와 독점 인터뷰 기회 확보를 위해 비판적 질문을 회피하는 ‘액세스 저널리즘’을 실행한다는 것이다. 참고로 액세스 저널리즘은 “진실 추구보다는 정치, 산업, 문화, 스포츠 등에서 영향력 있는 인물과의 인터뷰나 접근을 통해 얻은 정보를 중요하게 생각하는 취재관”을 의미한다.

언론에서 AI를 의인화하는 표현들 역시 AI에 대한 대중의 오해를 더욱 강화한다. 한국에서도 임지선 기자가 ‘생성형 인공지능 열풍과 거품론'(2024)에서 AI 관련 기사 상당수가 취재 없이 기업 보도자료에 의존하고 있다는 유사한 문제의식을 제기한 바 있다.

저자들은 AI 발전의 사유화 경향에 대해서도 우려를 표했다. 인류의 역사에서 AI 연구는 개방적이고 공공적 성격을 띠며 널리 공유되어 왔지만, 최근 몇 년간 구글, 오픈AI, 앤스로픽 같은 기업들이 경쟁을 이유로 생성형 AI 모델 관련 연구 성과 공개를 중단하면서 공공지식이 영업비밀로 전환되고 있다.

예측형 인공지능 분야에서 더욱 문제가 심각하다. 제대로 작동하지 않으면서도 투명하지도 않은 서비스들이 정확성, 공정성, 효율성을 내세워 판매되고 있으며, 기업들은 이익만 챙기고 책임은 회피하고 있다.

망가진 기관: AI 뱀 기름 현상이 번성하는 이유

그러나 저자들은 이런 문제의 근본 원인을 AI 자체에서 찾지 않는다. 예측 AI를 판매하고 싶은 회사들, 화려한 결과를 발표하고 싶은 연구자들, 그리고 선정적인 관심을 끌기 위해 선정적인 주장을 하는 기자들과 공인들로 인해 ‘AI 뱀 기름’은 번성하고 있지만, 진짜 문제는 이러한 허상에 대한 수요를 만드는 ‘망가진 기관(broken institutions)’에 있다고 진단하고 있다.

자금 부족과 구조적 문제에 시달리는 기관들이 비용 절감이라는 명목으로 검증되지 않은 AI를 성급하게 도입하면서 문제가 발생한다는 것이다. 이러한 인공지능이 약속하는 비용 절감이 과연 효율적일까. 현실은 그렇지 않다.

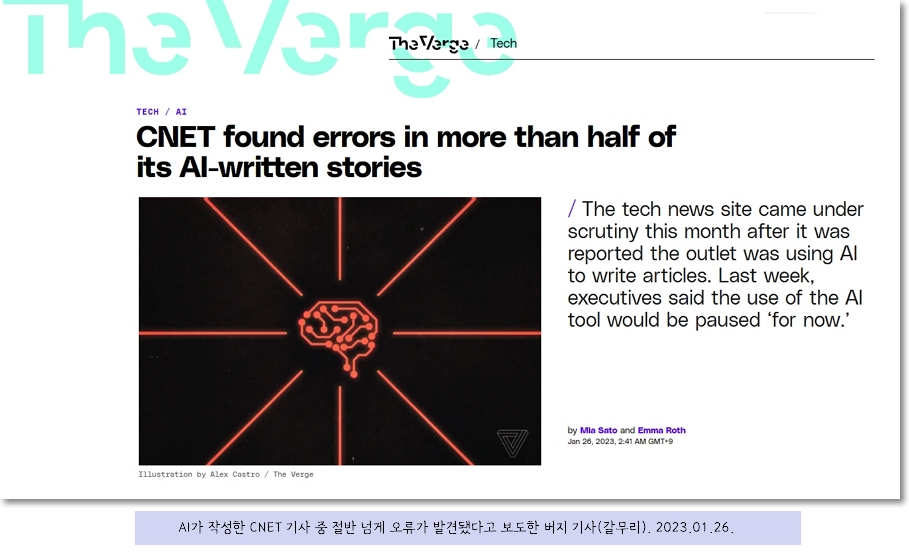

언론사인 CNET는 2022년 11월부터 2023년 1월 사이에 생성형 AI를 이용하여 77개의 기사를 작성했다. 회사는 각 기사의 발행 전 사실 확인을 거쳤다고 주장했으나, 무려 41개의 기사에서 오류가 발견되었다. 결국 인공지능 도구가 약속했던 효율성 향상이 물거품이 되었고, 이러한 폭로 이후 기사에 생성형 AI 사용은 중단해야 했다.

ChatGPT 등장 후 교육계에서도 비용 절감을 위해 ‘AI 텍스트 탐지 도구’들이 해결책으로 제시되었지만, 실제로는 전혀 작동하지 않을뿐더러 비영어권 화자들을 차별하는 부작용만 낳고 있다.

AI 리터러시로 AI 부작용 해결할 수 있을까…

저자들은 규제의 한계를 언급하며 인공지능이 건전하게 발전하기 위해서는 무엇보다 어린 시절부터의 AI 리터러시, 즉 교육의 중요성을 강조한다. 하지만 AI 리터러시가 이미 사유화가 급속도로 진행된 AI 문제를 해결할 수 있을까.

현재 AI는 이메일 작성과 번역 등에서 유용함을 보여주지만, ‘AI 뱀 기름’을 걸러내기 위한 인공지능 FDA(미 식품의약국) 역할을 할 제도적 장치는 여전히 부족하다.

우리나라는 2026년 1월 시행 예정인 ‘인공지능법’을 제정했지만, 투명성과 책임성을 실질적으로 강제할 수단은 미흡하다. 이미 여러 해악과 부작용들이 드러나고 있는 사례들을 마주하며, AI 연구와 산업 발전에서 후발주자인 우리나라는 추상적인 진흥책을 넘어서 구체적인 투명성과 책임성을 함께 지향하는 균형 잡힌 정책 비전을 마련해야 할 시점이라는 생각이 든다.

📚 김보라미의 ‘번역자 구함’

김보라미(변호사, 디케)의 이 서평은 언론개혁시민연대 정책위원회에서 발행하는 뉴스레터 ‘미디어 후토크-번역자 구함’에 게재된 글을 퇴고하여 게재하였습니다. 뉴스레터 홈페이지에서 언론개혁시민연대 정책위원회에서 발행하는 ‘미디어후토크’ 뉴스레터 홈페이지에서 구독신청 및 지난 레터를 모아 볼 수 있습니다.

그래프에서 우리나라 사람이 제일싸다고 기업마다 앞다투어 적용했던 그 단어가 눈에 띄는군요

Video interviews 책에 소개했다는 근본적인 원인이 뭘까 궁금해지네요 근데 그보다 재밌는 나라인듯 합니다 우리나라인데 현대는 그 x통을 파면 팔수록 호기심을 자극하네요.

그래프에서 우리나라 사람이 제일싸다고 기업마다 앞다투어 적용했던 그 단어가 눈에 띄는군요 Video interviews 책에 소개했다는 근본적인 원인이 뭘까 궁금해지네요 근데 그보다 재밌는 나라인듯 합니다 우리나라인데 현대는 그 x통을 파면 팔수록 호기심을 자극하네요.

========

근처에서 책을 일부만 빌려볼 수 없어 ai에게 물어봤는데요

정보누출과 인간성 결여 사회적 윤리적 위험을 초래한다고 하는군요

우리나라는 대단하게도 거리낌없이 도입한거네요

근데 이거 사실 ai한테 물어볼거없이 그냥 돈밖에 없구나라는 생각이 바로 들지 않나요?

이 정도면 우리는 너무 쉽게 우리의 존엄성을 포기해버리는거 아닌가 싶은데요