[AI in a Week by 테크프론티어] AI 시대, 미래의 데이트는 어떤 모습일까요? 한 주일의 주요 AI 뉴스, 논문, 칼럼을 ‘테크프론티어’ 한상기 박사가 리뷰합니다. (⌚10분)

1. AI 클론, 데이트의 미래?

- 출처: Are A.I. Clones the Future of Dating? I Tried Them for Myself (뉴욕타임스 11월 14일)

AI를 이용해 자신의 클론을 만들고 이를 이용해 데이트하는 앱들이 나오고 있다. 뉴욕타임스 기자 엘리 탄이 이를 이용한 경험을 바탕으로 기사를 썼다.

이런 서비스 중 하나인 범블(Bumble)의 창업자는 이를 ‘데이팅 컨시어지’라고 부르고 그라인더(Grindr)의 CEO는 ‘북제(Duplicate)’ 또는 ‘합성물(Synthetics)’이라고 부른다. 영국 드라마들 보면 AI 로봇을 합성물이라고 부르는 경우가 많다.

영국 드라마 ‘블랙 미러’에 등장할 것 같은 이야기로 엘리 탄은 AI 앱, 웹사이트, 구독 서비스 등을 통해 사용했는데 어떤 사이트는 기존의 데이팅 앱과 유사하고 다른 것은 제3자 플랫폼이나 코칭 서비스와 같다고 한다.

대부분의 앱은 친한 친구에게 문자를 보내는 것처럼 대화를 통해 인공지능 봇을 훈련해 클론을 만들었다. 봇은 사용자를 모방하기 위해 말투와 매너리즘을 개인화했고, 일종의 개인 GPT를 만든 다음 데이트 대상을 찾게 한다. 실사용자가 다른 사람의 클론과 대화를 하거나 내 클론이 다른 실제 사람과 대화를 하기도 하며 음성 메모를 업로드 하면 대화에서 사용자의 목소리를 흉내 내기도 한다.

첫 번째 앱인 ‘아이스(Ice)’ 경우는 마치 고객 지원 서비스처럼 대화를 건조하게 하지만 자신이 좋아하는 술집과 레스토랑에 대한 대화는 예상보다 잘 해냈다고 한다. 두 번째로 한 볼라(Volar)는 클론이 다른 클론과 대화를 나누고 사용자가 이를 확인하도록 한다. 클론이 수백 명과 메시지를 주고받도록 할 수 있는 것이다. 그러나 클론 간의 ‘첫 데이트’는 상대방을 이해하는 데 거의 도움이 되지 않았고, 대화가 형식적으로 느껴져 실망스러웠다고 한다(볼라는 9월에 문을 닫았고 아이스도 이제는 대중에게 공개하는 상태가 아니다).

아모리(Amori)같은 데이팅 코치 앱은 아이메시지나 왓츠앱 데이터를 업로드하면 데이트 신청을 하고 싶은 사람에게 보낸 문자를 분석해 피드백을 보내 주는 여러 코치 캐릭터가 있다. 아모리의 조언 중 일부는 합격점을 줄 수 있지만 본인이 직접 생각해 낼 수 있는 것보다 나은 경우는 별로 없었다고 한다.

월간 사용자가 150만 명에 달하는 릿즈(Rizz)도 있는데, 대화 스크린 샷을 올리면 상대방에게 세 가지 유형의 답장을 생성하도록 요청할 수 있다. 예상했던 것보다 더 많은 답변이 나왔고, 심지어 농담으로 들릴 정도로 엉뚱한 답변도 있었는데 이를 통해 몇 번의 데이트를 할 수 있었다고 한다.

그러나 기자의 경험은 AI가 데이트 생활을 개선하는 데 거의 도움을 주지 않았고, 사실 상대방에게 보낸 메시지가 AI가 생성한 것이라고 말하기도 민망했다는 것이다. 그러나 앞으로 데이팅 앱에서 이런 기능을 지원하거나 메시징 서비스에서 제공한다면 이제 내가 대화하는 상대가 인간인지 AI 클론인지 신경을 써야 하거나 아니면 무척 마음에 드는 말만 하므로 자연스럽게 받아들일 것인지는 시간이 더 필요할 것이다. 초기 스타트업은 실패했지만, 앞으로는 많은 앱이 등장할 것으로 보인다.

2. AI의 수학 문제: 아직 갈 길 멀다 (프론티어매스 벤치마크)

- 출처: AI’s math problem: FrontierMath benchmark shows how far technology still has to go (벤처비트, 11월 11일)

생성형 AI가 다른 분야에서 성과를 보여도 수리 추론에서는 아직도 벽에 부딪히는 경우가 많다. 에포크AI에서 제공한 프론티어매스 벤치마크는 고등 수학의 경우는 아직도 멀었다는 것을 다시 한번 확인하게 해준다.

프론티어매스는 수백 개의 독창적인 연구 수준의 수학 문제 모음이다. 60명 이상의 저명한 수학자들과 협력해 독창적이고 매우 어려운 문제를 만들었더니 GPT-4o나 제미나이 1.5 프로, 클로드 3.5 소넷이라고 해도 전체 문제의 2% 미만만 풀 수 있었다. 문제는 완전히 새롭고 공개된 적이 없는 것으로 데이터 유출을 방지했다. 지금까지 사용한 GSM-8K나 MATH 같은 벤치마크에서는 90% 이상을 풀 수 있었는데 이는 데이터가 너무 알려졌다는 오염 문제가 있었다. 다시 말해 데이터에 특화해 성능을 높이는 것이 가능했다.

프론티어매스는 기본적인 암기나 패턴 인식으로 해결할 수 있는 문제가 아니고, 종종 인간 수학자도 몇 시간 또는 며칠의 작업이 필요한 수준으로, 계산수론에서 추상 대수 기하학에 이르기까지 광범위한 주제를 다룬다.

필즈상을 받았던 테런스 타오는 문제들이 매우 어렵고 문제를 풀려면 관련 분야 대학원생 같은 준전문가나 현재 AI와 많은 다른 대수론 패키지를 결합해야 한다고 말했다.

수학은 종종 여러 단계에 걸쳐 정확하고 논리적인 사고를 요구하며, 증명이나 솔루션의 각 단계는 이전 단계를 기반으로 하므로 단일 오류로 인해 전체 해답이 잘못될 수 있기 때문에 AI에는 특히 어려운 분야이다. 따라서 수학은 AI 추론 능력을 평가하는 데 이상적인 시험대가 될 수 있다.

수학 영역은 시스템이 답을 생성하는 것만으로는 충분하지 않고 문제의 구조를 이해하고 여러 계층의 논리를 탐색하여 올바른 해결책에 도달해야 하고 깨끗하고 검증할 수 있는 기준을 제공한다.

흥미로운 점은 문제를 푼 2% 미만의 경우도 추론 기능을 자랑했던 o1-프리뷰보다 제미니 1.5 프로와 클로드 3.5 소넷이 더 많은 문제 답을 맞혔다는 점이다. 대부분의 사람은 한 문제도 풀지 못하리라는 것이 수학자들의 의견이다.

앞으로 프론티어매스는 AI 시스템이 수학적 추론 능력을 갖추고 있는지 평가하는 데 매우 중요한 기준이 될 것이며 이 문제들을 푼다면 인간을 모방하는 것을 넘어서 진정한 이해에 가까운 무언가에 접근했음을 알 수 있을 것이다.

3. 챗GPT로 글 쓰는 학생을 위한 가이드 (오픈AI)

- 출처: A Student’s Guide to Writing with ChatGPT (오픈AI, 11월 14일)

챗GPT로 학생들이 글을 쓰는 것이 옳으냐에 대한 논의는 많이 있어 왔다. 이제는 어떻게 하면 좋은 도구로 사용할 수 있는가에 관한 방안 제시가 더 필요한 시대이다. 오픈AI는 챗GPT가 엄격한 사고와 명확한 글쓰기 기술을 개발하는 데 도움이 되는 강력한 도구가 될 수 있음을 강조하면서 사용 방법과 가이드를 제시했다. 각 방안에는 사례 프롬프트도 제시했다.

- 인용 작업을 위임하기

- 새로운 주제에 대해 빠르게 파악하기

- 관련 소스에 대한 로드맵 보기

- 구체적인 질문을 통해 충분히 이해하기

- 구조에 대한 피드백을 받아 아이디어 흐름을 개선하기

- 리버스 아웃라인으로 논리를 테스트하기: 리버스 아웃라인은 각 단락의 요점을 파악하여 에세이의 구조를 평가하는 기법이다. 글의 구조를 한눈에 파악하면 한 걸음 물러나서 생각의 논리적 흐름을 평가하는 데 도움이 될 수 있다.

- 소크라테스식 대화를 통해 아이디어를 발전시키기

- 반론을 요청하여 논문을 압박 테스트하기

- 역사상 가장 위대한 사상가들과 아이디어를 비교하기

- 반복적인 피드백을 통해 글의 완성도를 높이기

- 고급 음성 모드를 독서 도우미로 사용하기

- 그냥 해내려고만 하지 말고 기술을 연마하기

마지막으로 투명하게 사용 내용을 공개하기라는 조언을 추가했다. 이에 대해 장 물랑 리옹 3대학의 정보 및 통신 과학 교수인 아서 페레(Arthur Perret)가 이에 반박하는 ‘챗GPT로 글을 쓰지 않게 하기 위한 학생 가이드’ 라는 글이 재미있었다. 그는 오픈AI가 제안한 12가지 가이드를 조목조목 반박한다. 그러나 많은 얘기는 아직 LLM의 정확성 문제, 완전한 자연어 이해가 아니라는 점, 지식 기반이 아니고 신뢰할 수 없는 정보를 생성한다는 기존 비판을 반복하고 있다.

사실 학생들이 AI를 이용해 글을 쓰는 일에 대해서는 이제 어떻게 하면 더 잘 사용하고 문제가 적게 하거나 자신의 생각을 좀 더 체계적으로 구조화할 수 있는가를 가르쳐야 하는 시대다. 그래서 현장에서는 오픈AI의 가이드와 아서 페레의 비판을 둘 다 가르치면서 문제점을 확실히 인식하고 도구를 잘 사용할 수 있게 해야 할 것이다.

4. 5시간 15분 동안 이어진 렉스 프리드만 팟캐스트

- 출처: Dario Amodei: Anthropic CEO on Claude, AGI & the Future of AI & Humanity | Lex Fridman Podcast (렉스 프리드만 유튜브, 11월 12일)

유명 팟캐스터인 렉스 프리드만(Lex Fridman)이 앤스로픽의 다이로 아모데이, 아만다 아스켈, 크리스 올라와 무려 5시간 15분 동안 이야기를 나눈 팟캐스트가 화제였다.

전체 녹취 원고는 ‘여기’에서 볼 수 있다.

토의 내용은 확장 법칙의 한계 문제, 다른 회사들과 경쟁, 각 모델 및 클로드에 대한 비판, AI 안전 레벨(ASL) 단계, 거버넌스, 위대한 팀을 고용하는 것, 헌법 AI, 프롬프트 엔지니어링, 포스트 학습, 성격 학습, 중첩, 단조로움 등 거의 모든 주제에 대한 토의가 이루어졌다.

내용은 매우 길고 생각보다 전문적이라 여기에서 소개하는 것보다 관심 있는 분들이 시청하거나 전체 녹취 원고를 읽어 보기 바란다. 페이스북에서 이런 이슈를 깊이 있게 파고 있는 최승준 님이 8번에 걸쳐서 이를 정리하고 포스팅을 한 내용을 따라가 보는 것도 추천한다. 1편은 ‘여기’를 보기 바란다.

흥미로운 점은 아모데이가 AGI 실현 가능성을 2026년이나 2027년을 가깝게 잡는다는 점(물론 100년이 더 걸릴 수도 있다고 했지만), AGI의 문제는 권력 증가와 남용이라는 점, 그리고 2026년이나 2027년에는 아마도 100억 달러 또는 1,000억 달러 규모의 컴퓨팅 클러스터를 구성하고자 하는 야망이 있을 것으로 예측한 것이다.

확장 법칙의 한계에 대한 여러 얘기가 계속 나왔던 한 주이지만, 앤스로픽의 다리오 아모데이는 이를 아직 인정하지 않으며 알파고 제로에서 봤듯이 강화학습과 합성 데이터를 통해 이를 극복할 수 있을 것으로 전망한다.

5. 생성형 AI의 역설: 시간 절약과 업무 효율성이 초래하는 7가지 문제

- 출처: 7 ways gen AI can create more work than it saves (CIO, 11월 13일)

CIO 웹사이트의 마리아 코롤로프가 기고한 글이다. 한국어 판에 있는 글은 여기에 있다.

기업은 생성형 AI를 활용하면서 여러 성과를 만들어 낸다. JP 모건 체이스는 LLM 스위트를 14만 명에게 배포해 20억 달러의 가치를 창출했다고 한다. IDC의 보고서에서는 리더의 98%가 AI를 조직의 우선순위로 보고 있으며, 2030년까지 AI가 세계 경제에 19조9천억 달러 상당의 가치를 더하며 세계 GDP에 3.5% 만들어 낼 것이라고 했다.

오픈AI는 포춘 500대 기업의 92%가 자사 제품을 사용하고 GPT-4o가 나온 뒤 API 사용량이 두 배가 되었다고 한다. 그러나 한 조사에서는 응답자의 23%가 모델이 신뢰할 수 없고 프로젝트가 실패했다고도 한다.

코롤로프가 지적하는 문제는 다음과 같다.

- AI가 직원의 업무 속도를 개선한다고 해서 절감된 시간을 반드시 더 가치 있는 활동에 사용하지 않는다. 사람들은 더 많은 관리 업무로 그 시간을 채운다.

- 더 많은 정보는 생산성을 저해할 수 있다. 생성형 AI로 이메일을 10배 더 빨리 작성할 수 있다면 더 많은 이메일에 응답하게 되고 중요한 글이 아닌 글을 상대하고 더 많은 문서를 만들어 내면 관리자의 부하를 높인다.

- 더 많은 작업을 처리할 수 있으면 주의 파편화(attention fragmentation)가 되어 생산성에 부정적일 수 있다. 가치 창출 없이 업무만 창출하는 프로젝트, 이니셔티브, 팀의 폭발적인 증가가 나타날 수 있다.

- 도구가 너무 많고 각 도구마다 학습 곡선이 있다. 실제로 가치 창출까지는 일정 기간이 걸린다.

- 환각과 부정확성이 여전하다. 코넬대학교, 워싱턴대학교, 워털루대학교, 비영리 연구기관 AI2의 연구진이 최근 발표한 논문에서는 최상급 성능을 갖춘 모델조차도 완전히 정확한 응답을 제공하는 경우가 1/3에 불과했다. 슬랙 설문조사에 따르면 업무 관련 작업에서 AI 결과를 전적으로 신뢰할 수 있다고 답한 직장인은 7%에 불과했다.

- 미미한 성과에 너무나 방대한 데이터 과학을 사용한다. 가트너에 따르면 AI 프로젝트가 개념 증명 단계에서 벗어나질 못할 가능성이 높고 2025년 말까지 불분명한 비즈니스 가치, 데이터 품질 저하, 부적절한 리스크 관리, 비용 증가 등의 이유로 생성형 AI 프로젝트의 최소 30%가 중단될 것이라고 한다.

- 즉각적 결과에 대한 기대. 대학에서 사용을 위해서 준비하는 데 4개월 이상 걸리고, 마케팅 기업도 일부 시간이 절약되었지만 편집과 수정이 많이 필요했다. 그러나 전환하고 있다는 것이 더 중요하다는 의견이다.

타다 컨설팅 기업의 견해는 고도로 타깃팅된 산업 활용에서 생산성 향상과 ROI(투자수익률)가 크다고 한다. 아직은 생성형 AI 도구가 초기 단계이고 이는 인터넷 초기와 비슷하다는 것이다.

6. 그 밖의 소식들

- EU 집행위가 독립 전문가들이 작성한 범용 AI 실행 강령 초안 발표했다.

- ‘시스템적 위험 유형’ 목록에는 통제력 상실, CBRN 위험, 자동화된 AI R&D를 포함한다.

- 시스템적 위험이 있는 GPAI 모델을 개발하는 모든 개발자는 ‘안전 및 보안 프레임워크’를 만들어 게시해야 한다.

- 기업은 “의미 있는 독립적인 전문가 위험 및 완화 평가를 활성화”해야 하며, 여기에는 “모델 기능에 대한 독립적인 테스트가 포함될 수 있음”을 고려해야 한다.

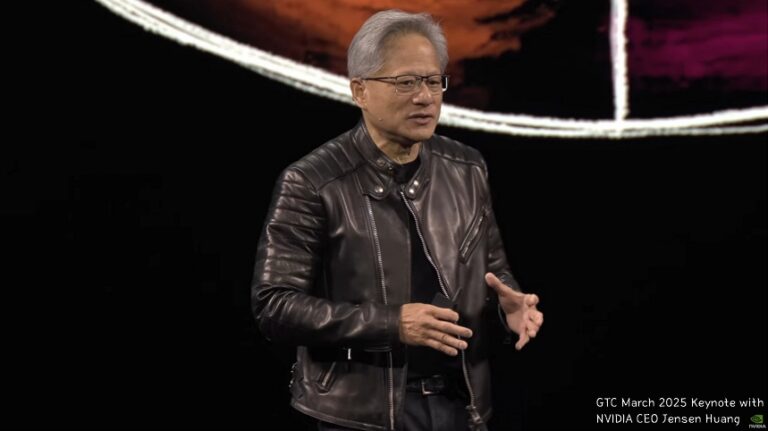

- 소프트뱅크가 엔비디아의 블랙웰을 이용해 일본에 가장 강력한 AI 슈퍼 컴퓨터를 만들 계획이다.

- 세계 최초로 NVIDIA DGX™ B200 시스템을 받을 예정이며, B200은 새로운 NVIDIA DGX SuperPOD™ 슈퍼컴퓨터의 구성 요소가 될 것이다.

- 구글 딥마인드는 알파폴드 3를 오픈 소스로 공개했다.

- 소스 코드와 모델 가중치를 공개했다.

- 공개한 깃허브 주소는 ‘여기‘다.

- 영국의 AI 안전연구소가 1주년 기념으로 현재까지의 작업과 미래 계획을 소개했다.

- 또한, LLM 벤치마크 평가 저장소인 Inspect Evals를 발표했다.

- 알리바바가 GPT-4o의 코딩 수준에 맞먹는 Qwen2.5-coder를 발표했다.

- 구글이 제미나이를 아이폰 앱으로 발표했다.